DWD层怎样解析事件表数据

1、1 创建基础明细表明细表用于存储ODS层原始表转换过来的明细数据。

2、1)创建事件日志基础明细表

3、2)说明:其中event_name和event_json用来对应事件名和整个事件。这个地方将原始日志1对多的形式拆分出来了。操作的时候我们需要将原始日志展平,需要用到UDF和UDTF。

4、2 自定义UDF函数(解析公共字段)

5、1)创建一个maven工程:hivefunction

6、2)创建包名:com.atguigu.udf

7、3)在pom.xml文件中添加如下内容

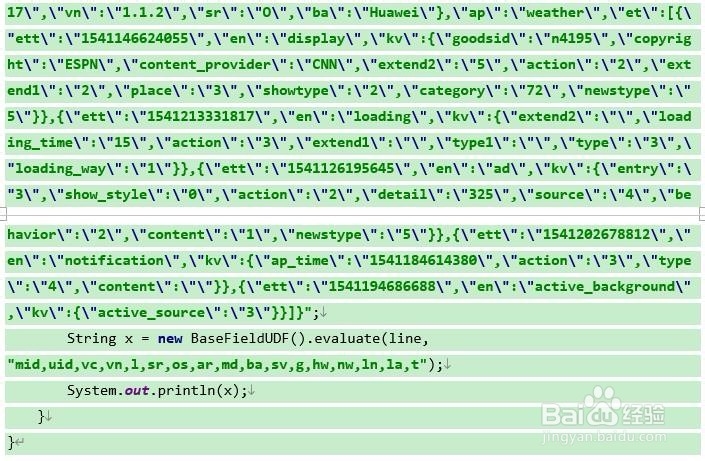

8、4)UDF用于解析公共字段

9、注意:使用main函数主要用于模拟数据测试。

10、3 自定义UDTF函数(解析具体事件字段)

11、1)创建包名:com.atguigu.udtf

12、2)在com.atguigu.udtf包下创建类名:EventJsonUDTF

13、3)用于展开业务字段

14、2)打包

15、3)将h坡纠课柩ivefunction-1.0-SNAPSHOT上传到hadoop102的/opt/module/hive/

16、4)将jar包添加到Hive的classpath

17、5)创建临时函数与开发好的java class关联

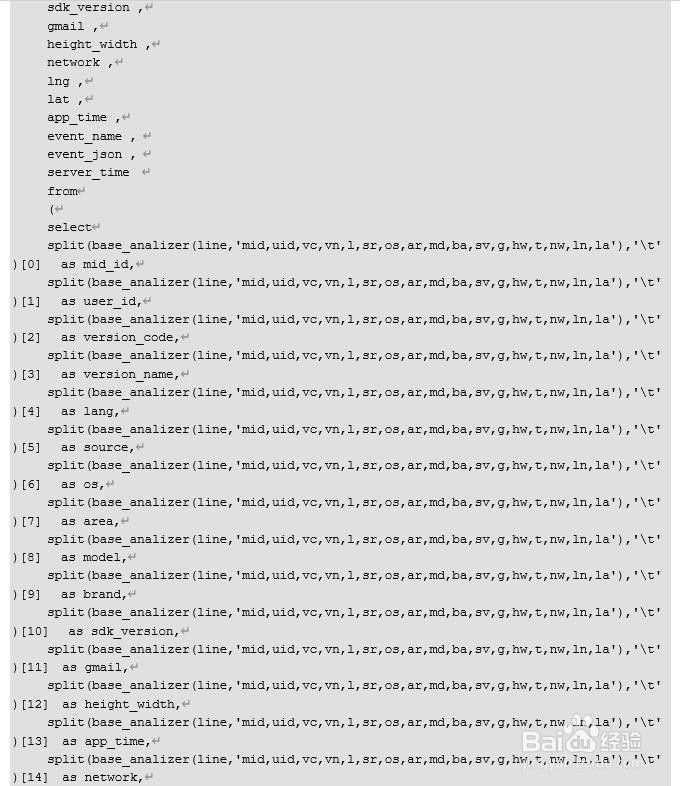

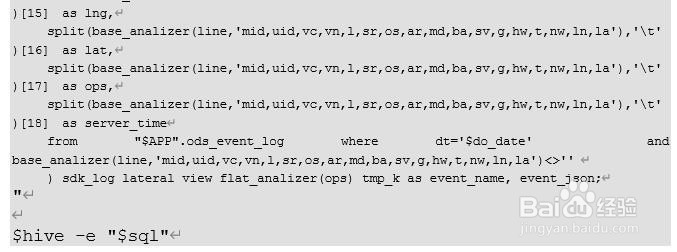

18、4 解析事件日志基础明细表1)解析事件日志基础明细表

19、2)测试

20、5 DWD层数据解析脚本1)在hadoop102的/home/atguigu/bin目录下创建脚本

21、在脚本中编写如下内容

22、2)增加脚本执行权限

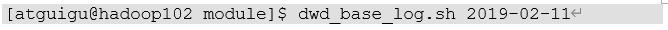

23、3)脚本使用

24、4)查询导入结果

25、5)脚本执行时间开发中一般在每日凌晨30分~1点

声明:本网站引用、摘录或转载内容仅供网站访问者交流或参考,不代表本站立场,如存在版权或非法内容,请联系站长删除,联系邮箱:site.kefu@qq.com。