如何用Python编写爬虫程序

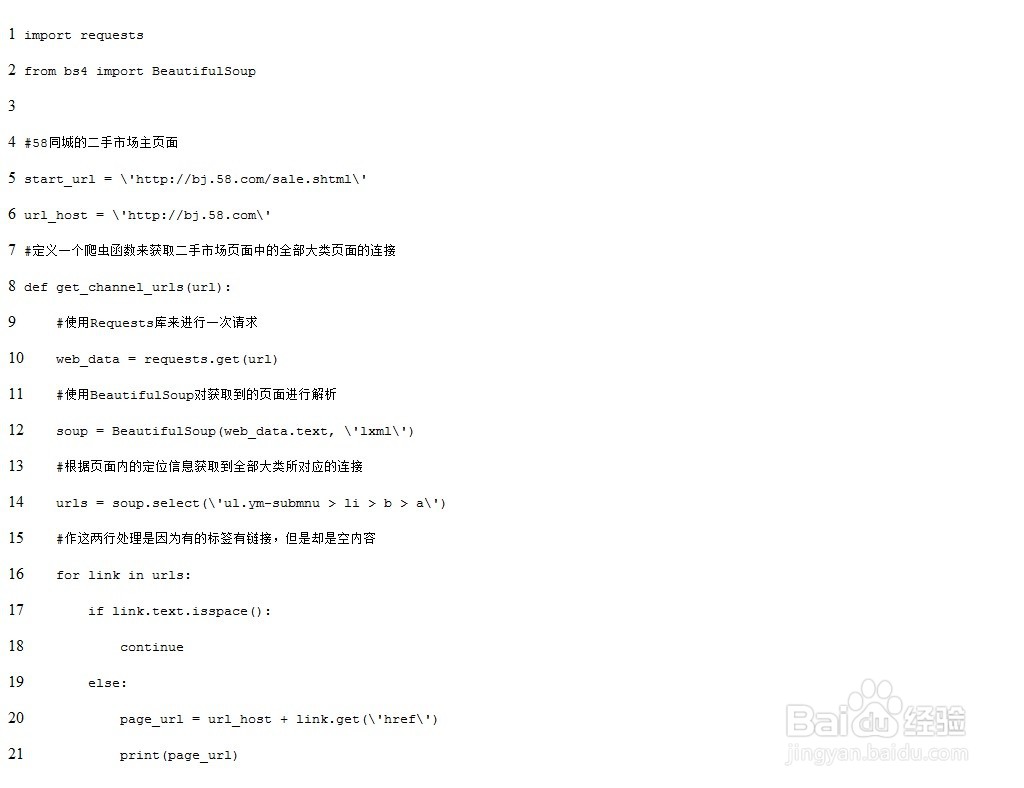

2、用python写爬虫的流程和思路如下,有需要的小伙伴可以借鉴..1. 整体思路流程通过URL获取说要爬取的页面的响应信息(Requests库的使用)通夸臾蓠鬏过python中的解析库来对response进行结构化解析(BeautifulSoup库的使用)通过对解析库的使用和对所需要的信息的定位从response中获取需要的数据(selecter和xpath的使用)将数据组织成一定的格式进行保存(MongoDB的使用)通过对数据库中的数据进行筛选和组织,进行数据可视化的初步展示(HighCharts库的使用)2. 简单代码演示准备工作下载并安装所需要的python库,包括:requests库:用于向指定url发起请求BeautifulSoup库:用于解析返回的网页信息lxml库:用于解析网页返回结果pymongo库:用于实现python对MongoDB的操作3. 对所需要的网页进行请求并解析返回的数据对于想要做一个简单的爬虫而言,这一步其实很简单,主要是通过requests库来进行请求,然后对返回的数据进行一个解析,解析之后通过对于元素的定位和选择来获取所需要的数据元素,进而获取到数据的一个过程。(更多学习内容,请点击python学习网。)一个简单的网络爬虫示例

3、以上就是一个简单的网页爬虫的制作过程,我们可以通过定义不同的爬虫来实现爬取不同页面的信息,并通过程序的控制来实现一个自动化爬虫。

声明:本网站引用、摘录或转载内容仅供网站访问者交流或参考,不代表本站立场,如存在版权或非法内容,请联系站长删除,联系邮箱:site.kefu@qq.com。

阅读量:91

阅读量:85

阅读量:66

阅读量:82

阅读量:21