网站robots.txt标准写法及实例

1、首先介绍一下功熹栳缂靖能设置:User-agent: * 表示允许所有蜘蛛采集;disallow告诉蜘蛛不要抓取某些文件或目录。如下面代码将阻止蜘蛛抓取所有的网站文件(/代表跟目录):User-a爿讥旌护gent: *Disallow: /Allow: /告诉蜘蛛应该抓取某些文件。Allow和Disallow配合使用,可以告诉蜘蛛某个目录下,哪些内容可以抓取,哪些内容禁止抓取。如下面代码将使蜘蛛不抓取wp-admin目录下其他文件,而只抓取其中ab下的文件:User-agent: *Disallow: /wp-admin/Allow: /wp-admin/ab

2、下面介绍一下通配符:$通配符 -User-agent: *Allow: .htm$*通配符 - 告诉蜘蛛匹配任意一段字符。如下面一段代码将禁止蜘蛛抓取所有htm文件:User-agent: *Disallow: /*.htm

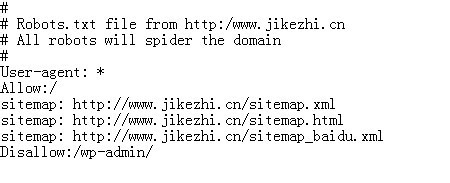

3、下面以我的网站为例子示范一下,根据协议,极客志网站的robots.txt协议为:# # Robots.txt file from http:/www.jikezhi.cn # All robots will spider the domain # User-agent: *Allow:/sitemap: http://www.jikezhi.cn/sitemap.xmlsitemap: http://www.jikezhi.cn/sitemap.htmlsitemap: http://www.jikezhi.cn/sitemap_baidu.xmlxiDisallow:/wp-admin/

5、写好之后把文件重命名为:robots.txt 然后上传到网站的根目录下面,切记不是主题的根目录下而是网站的根目录。

6、如果你不想自己动手去写,可以安装一个wordpress插件:KB Robots.txt 直接在网站后台插件搜索安装启用即可。