增加OSD解决Ceph集群不可用的问题

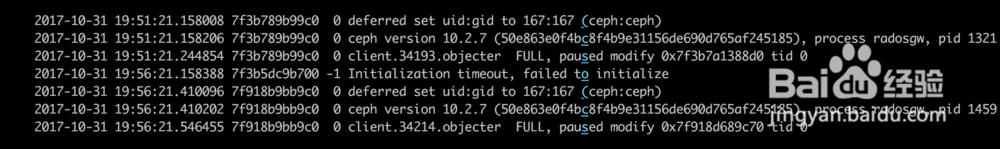

1、一稍僚敉视个服务连接不上ceph的对象存储网关,重启ceph对象存储网关,也不生效。查看网关日志发现:2017-10-31 19:51:21.158008 7f3b789b99c0 0 de熠硒勘唏ferred set uid:gid to 167:167 (ceph:ceph) 2017-10-31 19:51:21.158206 7f3b789b99c0 0 ceph version 10.2.7 (50e863e0f4bc8f4b9e31156de690d765af245185), process radosgw, pid 1321

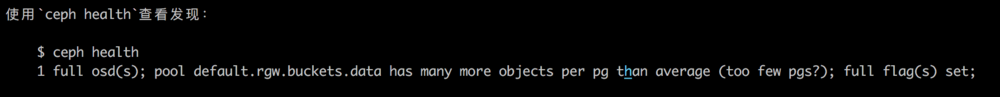

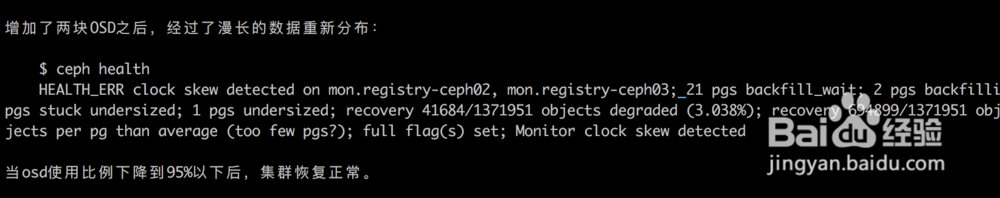

2、使用`ceph health`查看发现: $ ceph health 1 full osd(s)挢旗扦渌; pool defau造婷用痃lt.rgw.buckets.data has many more objects per pg than average (too few pgs?); full flag(s) set;

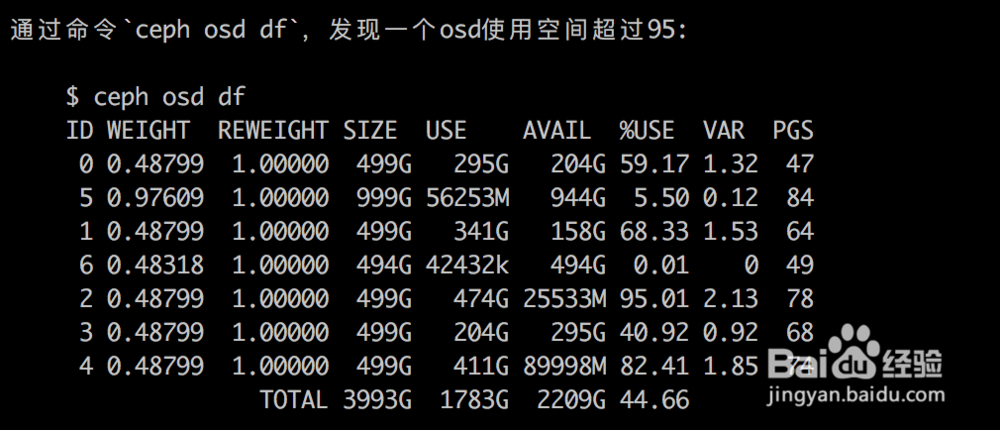

3、通过命令`ceph osd df`,发现一个osd使用空间超过95%: $ ceph osd df

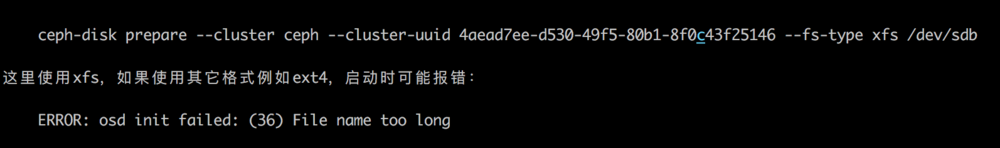

4、在一个node上增加一个磁盘后,执行(注意替换cluster-uuid和磁盘名称): ceph-disk prepare --cluster ceph --cluster-uuid 4aead7ee-d530-49f5-80b1-8f0c43f25146 --fs-type xfs /dev/sdb

5、如果磁盘没有自动挂载,手动active: ceph-disk activate /dev/sdb

6、之后等待ceph的数据重新分布完成即可。

声明:本网站引用、摘录或转载内容仅供网站访问者交流或参考,不代表本站立场,如存在版权或非法内容,请联系站长删除,联系邮箱:site.kefu@qq.com。

阅读量:24

阅读量:46

阅读量:21

阅读量:46

阅读量:50